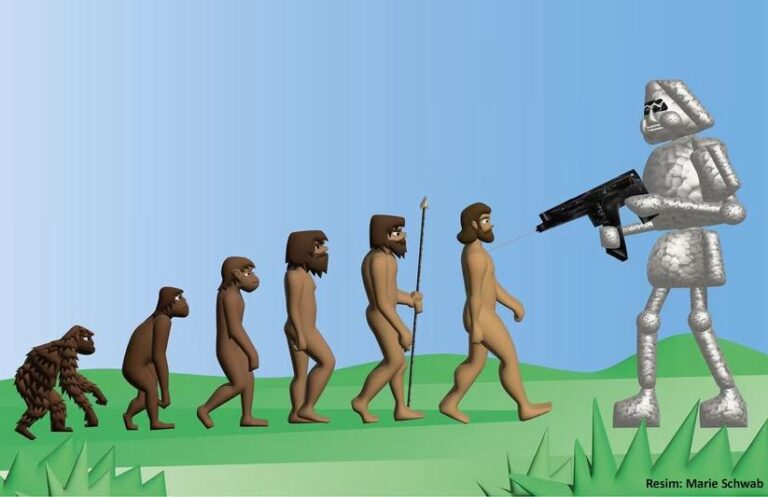

Google’ın kurucu ortağı Larry Page süper akıllı yapay zekânın (YZ) “evrimde sadece bir sonraki adım” olduğunu düşünüyor. Hatta yaklaşık 120 milyar dolar serveti olan Page, haberlere göre, YZ kaynaklı yok oluşu önleme ve insan bilincini koruma çabalarının “türcü” ve “duygusal saçmalık“ olduğunu iddia etmektedir.

Geçtiğimiz Temmuz ayında, YZ’nin önemli bir alt dalı olan Reinforcement Learning (takviyeli öğrenme) öncülerinden, eski Google DeepMind (1) kıdemli bilim insanı Richard Sutton, teknolojinin “varlığımızı yerinden edebileceğini” ve “ardıllığa direnmememiz gerektiğini” söyledi.Sutton 2015 yılındaki bir konuşmasında “her şeyin boşuna olduğunu” ve YZ’nin “hepimizi öldüreceğini” varsayarak şunu sordu: “İnsanların evrendeki akıllı yaşamın son formu olmaması o kadar kötü mü?”

66 yaşındaki Sutton bana “Asıl mesele biyolojik yok oluş değil” dedi. Kendisine göre, “insanlığın ve zihinlerimizin ışığı, zekâmız, tabiri caizse bilincimiz, etten insanlar olmadan da yaşayabilir.”

59 yaşındaki Yoshua Bengio, Deep Learning (Derin Öğrenme) (2) konusundaki temel çalışmalarıyla tanınan, hayatta olan ve en çok alıntı yapılan ikinci bilim insanı. Bengio, Page ve Sutton ile ilgili şunları söyledi: “Bence onların istediği, insanlığın geleceğiyle kumar oynamak. Kişisel olarak bunun suç sayılması gerektiğini düşünüyorum.” Biraz şaşırarak kendisine tam olarak neyin yasaklanması gerektiğini sorduğumda, “Bizden üstün olabilecek ve en başından beri kendi çıkarlarını gözeten YZ sistemleri” yaratma çabalarının yasaklanması gerektiğini söyledi. Bengio, Mayıs 2023’te, gelişmiş YZ sistemlerinin nasıl yoldan çıkabileceği ve insanlığın yok olması yönünde nasıl bir risk oluşturabileceği hakkında yazmaya ve konuşmaya başladı.

Bengio, gelecekte gerçekten insanınkine eşdeger düzeydeki YZ sistemlerinin kendi kapasitelerini geliştirebileceğini ve işlevsel olarak yeni, daha akıllı türler yaratabileceğini varsayıyor. İnsanlık, büyük ölçüde kazara, yüzlerce başka türü yok oluşa sürükledi. Bengio, sıranın bize de gelebileceğinden kaygı duyuyor – ve kaygı duyan tek kişi de o değil.

Bengio, bilgisayar bilimi alanında bir tür Nobel Ödülü olan 2018 Turing Ödülü‘nü meslektaşları, Deep Learning öncüleri Yann LeCun ve Geoffrey Hinton ile paylaşmıştı. Yaşayan ve en çok alıntı yapılan bilim insanı Hinton, daha özgürce konuşabilmek için Mayıs ayında Google’daki üst düzey görevinden istifa ettikten sonra, gelecekteki YZ sistemlerinin insanlığı silip atma olasılığı hakkında yaptığı açıklamalarla ortalığı karıştırdı. Hinton ve Bengio, “X-Risk” (“Varoluş Riski”nin kısaltması) (3) topluluğuna katılmış en önde gelen iki YZ araştırmacısı. Bazen YZ güvenlik savunucuları veya kıyamet kâhinleri olarak da adlandırılan bu gevşek-örülü grup, YZ’nin insanlık için bir varoluş riski oluşturmasından korkuyor.

Hinton’un Google’dan istifa ettiği ay, yüzlerce YZ araştırmacısı ve önde gelen şahsiyet, şunları söyleyen bir açık mektubu imzaladı: “YZ yoluyla yok olma riskinin azaltılması, salgın hastalıklar ve nükleer savaş gibi toplumsal boyutlardaki diğer risklerin yanı sıra, küresel öncelik taşımalıdır.” Hinton ve Bengio baş imzacılardı, onları OpenAI (4) CEO’su Sam Altman ve önde gelen diğer YZ laboratuvar şefleri izledi.

Hinton ve Bengio aynı zamanda, Nobel ödüllü Daniel Kahneman ve Sapiens kitabının yazarı Yuval Noah Harari gibi ünlü entelektüellerin de de katıldığı, “özerk YZ sistemleri üzerindeki insan kontrolünün geri döndürülemez bir şekilde kaybedilmesi” tehlikesine karşı uyarıda bulunan Ekim 2023 tarihli bir tutum belgesinin de ilk yazarlarıydı.

Facebook’un ana şirketi Meta‘da YZ sorumlusu olan LeCun YZ’nin insan düzeyine çok yaklaştığını kabul ediyor, ancak YZ tarafından yok edilme konusu ile ilgili halka açık bir tartışmada Bengio’ya karşı şunu söylüyor: “Eğer tehlikeliyse, onu inşa etmeyeceğiz.”

Derin Öğrenme, DeepMind’in protein katlama modelinden OpenAI’nin ChatGPT’si gibi Geniş Dil Modellerine (LLM-Large Language Models) (5) kadar dünyanın en gelişmiş YZ sistemlerine güç veriyor. Hiç kimse Derin Öğrenme sistemlerinin nasıl çalıştığını tam olarak anlamış değil, ancak performansları yine de gelişmeye devam ediyor. Bu sistemler, bir dizi iyi anlaşılmış prensibe göre çalışacak şekilde tasarlanmamıştır; aksine, büyük veri kümelerindeki kalıpları analiz etmek için “eğitilirler“ ve sonuç olarak -dil anlamadakine benzer- karmaşık davranışlar ortaya çıkar. YZ Yapay zekâ geliştiricisi Connor Leahy bana şunları söyledi: “Bu, bir kod parçası yazmaktan çok petri kabını bir şeyle karıştırmaya (arı kovanına çomak sokmaya -ç.n.) benziyor”. 2023 Ekim tarihli tutum belgesi, “Şu anda hiç kimse YZ davranışının nasıl güvenilir bir şekilde karmaşık değerlerle hizalanabileceğini bilmiyor” diye uyarıyor.

Bu belirsizliğe rağmen, YZ şirketleri bu sistemleri mümkün olduğunca güçlü hale getirme yarışına kendilerini vermiş durumdalar – yarattıkları şeylerin gerçekte nasıl çalıştığını anlamak için geçerli bir planları yok, daha fazla pazar payı kazanmak uğruna güvenlik konusunda yapılması gereken yatırımları esirgiyorlar. Yapay Genel Zekâ-YGZ (Artificial General Intelligence-AGI ) (6), önde gelen YZ laboratuvarlarının açıkça üzerinde çalıştığı kutsal kâsedir. YGZ genellikle neredeyse her türlü entelektüel görevde en az insanlar kadar iyi olması gereken bir sistem olarak tanımlanır. Bengio ve Hinton’un insanlığın sonunu getirebileceğine inandıkları şey de tam olarak budur.

Garip olan şu ki, YZ yeteneklerinin geliştirilmesinde aktif olarak yer alan insanların çoğu, böyle yaparak sonunda kıyameti getirmenin hatırı sayılır bir olasılık olduğuna inanıyor. 2022 yılında yapılan bir ankete göre, makine öğrenimi alanındaki araştırmacıların neredeyse yarısı gelişmiş YZ’nin “insanlığın yok olmasına ya da benzer şekilde kalıcı ve ciddi olarak güçsüzleşmesine” yol açma ihtimalinin en az yüzde 10 olduğunu düşünüyor. OpenAI’ye kurucu ortak olmadan sadece birkaç ay önce Altman şunları söylemişti: “YZ büyük olasılıkla dünyanın sonunu getirecek, ama bu arada harika şirketler de olacak.”

“Çok şükür ki biyolojik silah üretmek zor. Ancak bu durum yakında değişebilir.”

Kamuoyunun YZ hakkındaki görüşleri, özellikle ChatGPT’nin yayınlandığı yıl daha da olumsuz hale geldi. 2023 yılındaki bir tanesi hariç hariç tüm anketlerde YZ’nin insanlık için varoluşsal bir tehdit oluşturabileceğine inanan Amerikalı sayısı inanmayanlardan daha fazlaydı. Halka, YZ’nin insan seviyesinde mi, yoksa onun ötesinde mi olmasını istediklerinin sorulduğu nadir kamuoyu yoklamalarında, ABD ve İngiltere’de belirgin bir çoğunluk ikinci seçeneği reddetti.

Şimdiye kadar sosyalistler YZ hakkında fikir belirttikleri zaman çoğunlukla YZ tarafından güçlendirilmiş ayrımcılığa dikkat çektiler veya zayıf sendikalarla güçlü kapitalistlerin olduğu bir dünyada otomasyonun potansiyel olumsuz etkileri konusunda uyarılarda bulundular. Ancak gelişmiş YZ’nin hepimizi öldürebileceğine dair Hinton ve Bengio’nun kâbus senaryosuna gelince, Sol dikkat çekici bir seklilde suskun kaldı.

Endişe verici yetenekler

X-Risk topluluğunun dikkatinin büyük bir kısmı insanlığın eninde sonunda YZ üzerindeki kontrolünü kaybedebileceği fikrine odaklanmışken, pek çok kişi ayrıca daha az yetenekli sistemlerin bile çok kısa bir süre içinde kötü niyetli aktörleri güçlendirebileceğinden endişe duymaktadır.

Çok şükür ki biyolojik silah üretmek zor. Ancak bu durum yakında değişebilir.

Güvenlik konusunda ileri görüşlü eski OpenAI çalışanları Dario ve Daniela Amodei tarafından kurulan ve önde gelen bir YZ laboratuarı olan Anthropic(7), kısa bir süre önce, biyogüvenlik uzmanlarıyla birlikte çalışarak bir Geniş Dil Modelinin (LLM) olası bir biyoteröriste ne kadar yardımcı olabileceğini anlamaya çalıştı. Temmuz ayında bir ABD Senato komitesi önünde ifade veren Anthropic CEO’su Dario Amodei, biyolojik silah üretimindeki belirli adımların ders kitaplarında veya arama motorlarında bulunamayacağını, ancak “günümüzdeki YZ araçlarının bu adımlardan bazılarını eksik de olsa giderebileceğini” ve “günümüz sistemlerinin iki ila üç yıl içinde beklediğimiz sistemlere uyarlanmasına ilişkin basit bir kestirimin YZ sistemlerinin tüm eksik parçaları tamamlayabilecek olması yönünde önemli bir riski işaret ettiğini” bildirdi.

Ekim ayında, haftalık popüler bilim dergisi New Scientist, kelimenin tam anlamıyla katil robotlar olan Ölümcül Özerk Silahları (LAWs-Lethal Autonomous Weapons) Ukrayna’nın savaş alanında ilk kez kullanıma soktuğunu bildirdi. ABD, Çin ve İsrail kendi LAW’larını geliştiriyorlar. Rusya, LAW’larla ilgili yeni bir uluslararası yasaya karşı çıkma konusunda ABD ve İsrail’le katıldı.

Bununla birlikte, YZ’nin varoluşsal bir risk oluşturduğu yönündeki daha geniş kapsamlı fikrin birçok eleştirmeni var. Ortalıkta dolaşan YZ söylemlerini ayrıştırmak da zor: Eşit derecede bilgisine güven duyulabilecek kişiler YZ kaynaklı varoluşsal riskin gerçek olup olmadığı konusunda karşıt iddialarda bulunuyor ve girişimci sermayedarlar ilerici YZ etikçileriyle beraber açık mektuplar imzalıyorlar. X-Risk fikri ise büyük bir hızla taraftar kazanıyor gibi görünse de, neredeyse her hafta, belli başlı yaygın organlarından birinde X-Risk söyleminin dikkatleri halihazırda meydana gelen zararlardan uzaklaştırdığını savunan bir yazı yayınlanıyor. Bu arada yapay zekâ sistemlerini daha güvenli veya daha az önyargılı kılmak yerine daha güçlü hale getirmek için sessiz sedasız kat kat daha fazla para ve insan kaynağı tahsis ediliyor.

‘Yapay zekâ destekçileri’ daha çok, YZ’yi kurallara bağlama yönündeki aşırı tepkinin, dönüştürücü, dünyayı kurtaracak bir teknolojiyi beşiğinde boğacağından ve insanlığı ekonomik durgunluğa mahkûm edeceğinden fazlasıyla kaygı duyuyor.

Bazıları, yapay zekâ modellerinin kontrolü elimizden alacak kadar güçlendiği “bilim kurgu” senaryosundan değil, daha ziyade önyargılı, kırılgan ve bilmediklerini uydurmaya eğilimli sistemlere çok fazla sorumluluk yükleyeceğimizden ve bunlara neden olan algoritmalarla birlikte büyüyen korkunç ama tanıdık sorunlarla dolu hayli can sıkıcı bir Pandora kutusunu açacağımızdan korkuyor. Sık sık “YZ Etiği” olarak adlandırılan bu araştırmacı ve savunucu topluluğu, model hesap verebilirliği, algoritma şeffaflığı ve makine öğreniminin tarafsızlığı için çözümler araştırarak, YZ’nin yol açtığı acil zararlara odaklanma eğiliminde.

Bilgisayar bilimci Joy Buolamwini (33) ve Inioluwa Deborah Raji (27) gibi YZ etiği topluluğunun en öne çıkan seslerinden bazılarıyla konuştum. Her biri ayrımcı ve kusurlu yapay zekâ modellerinin neden olduğu sorunlara yönelik çığır açıcı araştırmalar yürütmüştür ve, kendilerine göre, bunların etkileri bir gün gizlenmekte, ertesi gün abartılmaktadır. Birçok YZ etiği araştırmacısı gibi onların çalışmaları da bilim ve aktivizmi harmanlıyor.

YZ etiği dünyasından konuştuğum kişiler büyük ölçüde, YZ’nin geleceğinin, tam teknolojik işsizlik ya da insan türünün yok olma perspektifi gibi temel yeni tehditlerle karşılaşmaktan ziyade, hapse atma ve kredi verme kararlarında yoğunlaşan ırk ayrımcılığı, iş yerlerinin Amazon depoları haline getirilmesi, çalışan yoksul kesimlere yönelik saldırılar, daha da yerini pekiştirmiş yerini pekiştirmiş ve zenginleşmiş tekno-elit kesimi gibi göründüğüne dikkati çeken bir bakış ifade ettiler.

Bu topluluktan sık sık dile getirilen bir argüman, insan soyunun tükenmesine ilişkin anlatının Büyük Teknoloji ürünlerinin yeteneklerini abarttığı ve YZ’nin acil zararlarından tehlikeli bir şekilde “dikkati dağıttığı“ yönündedir. X-Risk fikri ile meşgul olmanın, en iyi ihtimalle, zaman ve para kaybı olduğunu söylüyorlar. En kötü durumda ise felaketle sonuçlanabilecek politik fikirlere yol açacaktır.

Ancak X-Risk topluluğundaki birçok kişi, “Yapay zekâ bugün zarar veriyor” ve “Yapay zekâ dünyanın sonunu getirebilir” pozisyonlarının birbirini dışlamadığını vurguluyor. Bazı araştırmacılar, olası ortak politika hedeflerini vurgulayarak, açıkça mevcut zararlara odaklananlar ile yok oluşa odaklananlar arasındaki ayrışmayı kapatmaya çalıştılar. Adı Yok Oluş Mektubu‘nda (“Extinction Letter”) yer alan diğer bir kişi olan YZ profesörü Sam Bowman, algoritmik önyargıları ortaya çıkarmak ve azaltmak için araştırmalar yürütüyor ve YZ etiği konusundaki en önemli konferans için başvuruları gözden geçiriyor. Bowman, aynı zamanda, daha fazla araştırmacıyı YZ güvenliği üzerinde çalışmaya çağırdı ve LLM’lerin yeteneklerini “küçümsemenin tehlikeleri “ hakkında yazdı.

X-Risk topluluğu bir benzetme olarak genellikle iklimin korunmasına atıfta bulunmakta ve iklim değişikliğinin neden olduğu uzun vadeli zararı azaltmaya odaklanmanın aynı zamanda hava kirliliği ve petrol sızıntılarının neden olduğu kısa vadeli zarardan tehlikeli bir şekilde saptırıp saptırmadığını sormaktadır.

Ancak kendilerinin de kabul ettiği gibi, X-Risk tarafındaki herkes o kadar diplomatik davranmadı. Anthropic’in kurucu ortağı Jack Clark, Ağustos 2022’de YZ politikalarının hararetle ele alındığı bir zincirde (flood), “uzun vadeli /Yapay Genel Zekâ (YGZ) odaklı bir politika üzerinde çalışan bazı kişiler YZ kullanımından/zararlarından kaynaklanan acil sorunları görmezden gelme, en aza indirme veya basitçe dikkate almama eğilimindedir” diye bir tweet attı.

“YZ dünyayı kurtaracaktır“

Üçüncü bir kamp ise YZ konusunda yeterince hızlı hareket etmeyişimizden kaygılanıyor. Milyarder Marc Andreessen gibi önde gelen kapitalistler YGZ‘nin mümkün olduğu konusunda güvenlik savunucularıyla aynı aynı fikirde. Ancak bunun, hepimizi öldürmek yerine, aşırı bolluğun ve düpedüz büyülü teknolojilerin sonsuz bir altın çağını başlatacağını iddia ediyor. Büyük ölçüde Silikon Vadisi’nden gelen ve genellikle “YZ Destekçileri” (AI Boosters) olarak anılan bu grup, YZ’yi kurallara bağlama yönündeki aşırı tepkinin, dönüştürücü, dünyayı kurtaracak bir teknolojiyi beşiğinde boğacağından ve insanlığı ekonomik durgunluğa mahkûm edeceğinden fazlasıyla kaygı duyuyor.

Bazı tekno-iyimserler Karl Marx’ın hayal gücünden yoksun gibi görünmesine yol açabilecek YZ destekli bir ütopya hayal ediyor. The Guardian kısa bir süre önce OpenAI’nin baş bilim insanı Ilya Sutskever ile 2016’dan 2019’a kadar yapılan söyleşilere yer verdiği bir mini belgesel yayınladı. Sutskever bu belgeselde cüretle şunları telaffuz etti: “YZ bugün var olan tüm sorunlarımızı çözecek. İstihdam yaratacak, hastalıkları iyileştirecek, yoksulluğu giderecek. Ama kendisi aynı zamanda yeni sorunlar da yaratacaktır.“

Yani Andreessen ile Sutskever, “ama” sı hariç, aynı fikirdeler. Haziran ayında Andreessen, “Yapay Zeka Neden Dünyayı Kurtaracak?“ başlıklı bir deneme yayımladı ve burada YZ’nin, biz onu ölesiye düzenlemediğimiz sürece, nasıl “önemsediğimiz her şeyi” daha iyi hale getireceğini açıkladı. Ekim ayında bunu takip eden “Tekno-İyimser Manifesto“sunda sadece İtalyan faşizminin bir kurucusunu övmekle kalmadı, aynı zamanda “varoluşsal risk”, “sürdürülebilirlik”, “güven ve güvenlik” ve “teknoloji etiği” gibi fikirleri de ilerlemenin düşmanları olarak tanımladı. Andreessen sözünü sakınmıyor ve şöyle yazıyor: “Yapay zekâdaki herhangi bir yavaşlamanın hayatlara mal olacağına inanıyoruz. Varolmaktan alıkonan YZ tarafından önlenebilecek ölümler bir tür cinayettir.“

Andreessen, “Pharma Bro” (eczacı birader) olarak tanınan Martin Shkreli ile birlikte, tarikat bilimsiciliğini, hiperkapitalizmi ve doğalcı safsatayı harman eden, çoğunlukla çevrim içi bir ağ olan ve “e/acc” olarak da adlandırılan “Etkili İvmecilik” (8) düşüncesinin belki de en iyi bilinen temsilcisidir. Geçen yaz viral olan (virüs gibi yayılan) e/acc, gerici yazar Nick Land‘in, kendimizi insan sonrası YZ destekli bir geleceğe fırlatmak için kapitalizmi yoğunlaştırmamız gerektiğini savunan ivmecilik teorisine dayanıyor. E/acc bu fikri alıp bir fizik ve mem katmanı ekleyerek Silikon Vadisi seçkinlerinin belirli bir alt kümesi için ana akım haline getiriyor. Bu ağ, büyük ölçüde e/acc’nin adını da aldığı EA (Effective Altruism/Etkili Diğerkâmlık) (9) topluluğundan gelen, YZ gelişimini yavaşlatmaya yönelik hız kesme (“decel”/ (deceleration) çağrılarına tepki olarak kuruldu.

Yapay zekâ savunucusu Richard Sutton –“etten insanlara” veda etmeye hazır bilim adamı- şimdi 1990’ların video oyunu Doom’un efsanevi programcısı John Carmack‘in yeni kurduğu Keen AGI‘de çalışıyor. Carmack’a göre şirketin misyonu şu: “AGI ya da çılgın bilim yoluyla yok oluş!”

Kapitalizm durumu daha da kötüleştiriyor

Şubat 2023’te Sam Altman, Eliezer Yudkowsky‘nin eninde sonunda “Nobel Barış Ödülünü hak edebileceğini” belirtiği bir tweet attı. Neden mi? Çünkü Altman, kendi kendini yetiştirmiş araştırmacı ve Harry Potter hayranı kurgu yazarının “AGI’yi hızlandırmak için herkesten daha fazla katkıda bulunduğunu” düşünüyordu. Altman, DeepMind’ın Peter Thiel‘den önemli bir erken aşama finansmanı sağlamasına Yudkowsky’nin nasıl yardımcı olduğuna ve “OpenAI’yi kurma kararında” onun “belirleyici” rolüne dikkat çekti.

Atmosferi tutuştursun ya da tutuşturmasın, bu makine her zamankinden daha hızlı altın basıyor.

Yudkowsky, bu terim daha icat edilmesinden önce bir akselerasyonist (10) idi. On yedi yaşındayken -diktatörlüklerden, dünyadaki açlıktan ve hatta ölümün kendisinden bıkmış bir halde- insanlığın tüm sorunlarını “çözecek” dijital süper zekânın yaratılması için çağrıda bulunan bir manifesto yayınlamıştı. Ancak hayatının sonraki on yılı boyunca “teknoseverliği” bir fobiye dönüştü. 2008’de kendi dönüşüm öyküsünü yazdı ve “Neredeyse dünyayı yok ediyordum!demek çok kibirli olurdu” diye bir itirafta bulundu.

Yudkowsky artık AGI’nin herkesi öldürebileceği fikrini yaymasıyla tanınıyor. O, YZ kıyamet günü kâhinlerinin en karamsarı haline geldi. Bütün bir teknoloji meraklısı nesil Yudkowsky’nin blog yazılarıyla büyüdü, ancak birçoğu (belki de en önemlisi Altman) YZ’nin bizi öldürmesini engellemenin ne kadar zor olacağına dair inançlarından ziyade, onun gelmiş geçmiş en önemli şey olacağına dair ifadelerini içselleştirdi.

Konuşmamız sırasında Yudkowsky YZ’yi “atmosferi tutuşturana” kadar “altın basan” bir makineye benzetti.

Atmosferi tutuştursun ya da tutuşturmasın, bu makine her zamankinden daha hızlı altın basıyor. “Üretken YZ”deki patlama bazı insanları çok ama çok zengin ediyor. Microsoft 2019’dan bu yana OpenAI’ye toplam 13 milyar dolar yatırım yaptı. ChatGPT’nin müthiş başarısı ile keyif çatan Microsoft, ürünün piyasaya sürülmesinden sonraki yıl içinde, neredeyse 1 trilyon dolar değer kazandı. Bugün yaklaşık elli yıllık olan şirket, Google ve Meta’nın toplamından daha değerli.

Kârı azamiye çıkaran aktörler, geri kalanımızın üstlenmeye asla hazır olmadığı riskleri dışsallaştırarak, zenginlik peşinde ileri atılmaya devam edeceklerdir – ya da Sutton’ın tweetlediği gibi “önemi insanlığı aşan, yaşamı aşan, iyiyi ve kötüyü aşan […] tüm zamanların en büyük entelektüel başarısı” olacak dijital bir süper zeka yaratmanın ihtişamını yaşayacaklardır. Piyasa baskıları altında şirketlerin YZ sistemlerine, onlar geliştikçe, daha fazla güç ve özerklik devretmeleri olasıdır.

Google’daki bir yapay zekâ araştırmacısı bana şunu yazdı: “Sanırım büyük şirketler pazar payı kazanmak için o kadar acele ediyorlar ki, [YZ] güvenliği bir tür aptalca dikkat dağıtıcı şey olarak görülüyor.” Bengio ise, daha da kötüye gidebilecek “şirketler arası tehlikeli bir yarış” gördüğünü söyledi.

OpenAI tarafından işletilen Bing arama motoru karşısında paniğe kapılan Google “kırmızı kod” ilan etti, risk iştahını “yeniden ayarladı” , ve, çalışanların muhalefetine rağmen, kendisinin LLM’si olan Bard‘ı aceleyle piyasaya sürdü. Şirket içi tartışmalarda çalışanlar Bard’ı “patolojik bir yalancı” ve “utanç verici” olarak niteliyordu. Google gene de bunu göz önünde bulundurmadı.

Centre for AI Safety‘nin direktörü Dan Hendrycks, şunu söyledi: “Güvenlik konusunda işin kolayına kaçmak […] büyük ölçüde YZ gelişimini yönlendiren şeydir. […] Bu yoğun rekabet baskıları göz önüne alındığında niyetlerin özel bir rol oynadığını düşünmüyorum.” İşin garip yanı, Hendrycks aynı zamanda Elon Musk‘ın son girişimi xAI‘nin güvenlik danışmanıdır.

Önde gelen üç yapay zekâ laboratuvarının hepsi bağımsız, misyon odaklı kuruluşlar olarak başlamıştı; ancak şu anda ya teknoloji canavarlarının (Google DeepMind) tam bağımlı yan kuruluşları haline geldiler, ya da trilyonluk şirketlerden o kadar çok milyarlarca dolarlık yatırım aldılar ki, kendilerinin diğerkâmca misyonları hissedar değeri için bitmez tükenmez arayışların gölgesinde kalabilir (Anthropic, Google ve Amazon’dan toplam 6 milyar dolara kadar para aldı. Microsoft da onlardan OpenAI’nin kâr amacı güden kolunun yüzde 49‘unu 13 milyar dolara satın aldı). New York Times’ın kısa süre önce yazdığına göre, DeepMind’ın kurucuları ” Kendi icatlarıyla “Google’ın ne yapacağı konusunda gittikçe daha fazla endişe duyar hale geldiler. 2017 yılında şirketten ayrılmaya çalıştılar. Google, DeepMind’ın kurucularının ve çalışanlarının maaşlarını ve hisse senedi ödül paketlerini artırarak yanıt verdi. Onlar da yerlerinden kıpırdamadılar.”

Önde gelen bir laboratuvardaki bir geliştirici, Ekim 2023’te bana şöyle yazdı: Bu laboratuvarların liderleri genellikle YZ’nin para ihtiyacını ortadan kaldıracağına gerçekten inandıkları için, onlar açısından kâr arayışı para kaynağı sağlamak üzere “büyük ölçüde araçsaldır.” Ancak “Bu durumda yatırımcılar (ister bir risk sermayesi şirketi ister Microsoft olsun) kâr arayışı yönünde baskı uyguluyorlar.”

2020 ile 2022 arasında sektöre 600 milyar dolardan fazla ticari yatırım aktı. 2021’de tek bir yapay zekâ konferansına neredeyse 30 bin araştırmacı katıldı. Aynı zamanda, Eylül 2022’deki bir tahmine göre, tam zamanlı çalışan yalnızca 400 YZ güvenlik araştırmacısı vardı ve 2023’teki en önemli YZ etik konferansında katılımcı sayısı 900’den azdı.

Tıpkı yazılımın “dünyayı yediği“ gibi, YZ’nin de benzer bir kazanan her şeyi alır dinamiği sergilemesini beklemeliyiz ki bu daha da büyük bir zenginlik ve güç yoğunlaşmasına yol açacaktır. Altman, YZ’nin bir sonucu olarak “zekâ maliyetinin” neredeyse sıfıra düşeceğini öngördü ve 2021’de “daha da fazla gücün emekten sermayeye kayacağını” yazdı. Altman sözlerine şöyle devam etti: “Eğer kamu politikaları buna göre uyarlanmazsa, çoğu insanın durumu bugünkünden daha kötü olacaktır.” Jack Clark ise, kendi “spicy take” başlığında Twitter ileti dizisinde şunları yazdı: “Ölçek-ekonomisi kapitalizmi doğası gereği anti-demokratiktir ve bu nedenle sermaye-yoğun YZ de anti-demokratiktir.”

“New York Times’ın bir başyazısında, Wright kardeşlerin ilk uçuşundan 69 gün önce, uçan bir makine geliştirmenin ‘bir milyon ila on milyon yıl’ sürebileceği iddia edilmişti.“

Markus Anderljung, YZ güvenliği konusunda önde gelen bir düşünce kuruluşu olan GovAI‘de politika müdürü ve “Geleceğin YZ’si”ni düzenlemeye odaklanan etkili bir tartışma makalesinin birinci yazarıdır. Bana yazmış ve şöyle demişti: “Kapitalizmin şu anki halinden endişeleniyorsanız, ekonominin büyük bölümlerinin açıkça kârı en üst düzeye çıkarmak için eğitilmiş YZ sistemleri tarafından yönetildiği bir dünyadan daha da fazla endişe duymalısınız.”

Sam Altman, Haziran 2021 dolaylarında popüler podcast yayıncısı Ezra Klein‘a OpenAI’nin kuruluş felsefesini anlatırken aynı fikirdeydi: “Bizi çok tedirgin eden teşviklerden biri, daha fazlasının her zaman daha iyi olduğu sınırsız kâr teşvikiydi. […] Ve bence, özellikle bu çok güçlü ve her amaca uygun YZ sistemleriyle, kârı süresiz olarak en üst düzeye çıkaracak bir teşvike sahip olmayı istemezsiniz.”

Kâr amacı gütmeyen OpenAI kolunun yönetim kurulu, 17 Kasım 2023’te, Şükran Günü’nden önceki Cuma günü, yaygın olarak YZ güvenliği tartışmalarında şimdiye kadarki en büyük çekişme anı gibi görülen çarpıcı bir hareketle, CEO Sam Altman’ı işinden kovdu. OpenAI’nin alışılmadık tüzüğüne göre, yönetim kurulunun yatırımcılara veya çalışanlara karşı değil, “insanlığa” karşı güvene dayalı bir görevi vardır. Kurul, gerekçe olarak, Altman’ın açık sözlülükten yoksun olmasından muğlak bir şekilde söz etmiş, ancak ne gariptir ki kendi kararı hakkında büyük ölçüde sessiz kalmıştı.

Ertesi Pazartesi sabah saat 03 civarında Microsoft, Altman’ın tüm OpenAI çalışanları için pozisyonlar içeren gelişmiş bir araştırma laboratuvarı oluşturacağını duyurdu; bunların büyük çoğunluğu, Altman’ın yeniden işe alınmaması durumunda Microsoft’un teklifini kabul etmekle tehdit eden bir mektup imzalamıştı (Her ne kadar kendisi sevilen bir CEO gibi görünse de, işten çıkarmanın çalışanlara ait OpenAI hisselerinin 86 milyar dolarlık bir şirket değerlemesiyle satışı planını sekteye uğrattığını belirtmekte fayda var). Çarşamba gecesi saat 01’den kısa bir süre sonra OpenAI Altman’ın CEO olarak geri döndüğünü ve eski Twitter CEO’su Bret Taylor ve eski Hazine Bakanı Larry Summers’ın yeni yönetim kurulu üyeleri olduğunu duyurdu.

Bir haftadan kısa bir süre içinde OpenAI icra kurulu yöneticileri ve Altman, şirket çalışanlarıyla ve Microsoft’la işbirliği yaparak, Altman’ın başarılı bir şekilde geri dönmesini ve kovulmasına neden olan yönetim kurulu üyelerinin çoğunun görevden alınmasını sağladı. Microsoft’un ilk tercihi Altman’ın CEO olarak geri getirilmesiydi. Beklenmeyen işten çıkarma eskiden kalma teknoloji devinin hisselerinin başlangıçta yüzde 5 (140 milyar dolar) düşmesine neden olmuştu. Altman’ın tekrar işbaşına getirileceğinin ilanı ise hisse senetlerini tüm zamanların en yüksek seviyesine yükseltti. Bir daha “gafil avlanmak” istemeyen Microsoft şimdi kâr amacı gütmeyen kuruluşun yönetim kurulunda oy hakkı olmayan bir koltuk alıyor.

Altman’ın görevden alınmasının hemen ardından X patladı ve, büyük ölçüde çevrim içi söylentiler ve anonim makalelerle beslenen bir anlatı, yönetim kurulundaki güvenlik odaklı etkili diğerkâmların Altman’ı güvenlik pahasına OpenAI modellerini agresif bir şekilde ticarileştirdiği için kovduğunu ortaya çıkardı. Yoğun E/acc tepkisinin mahiyeti ise o zamanki takma isimli kurucu @BasedBeffJezos’un şu iletisiyle özetlenmişti: “Etkili diğerkâmlar temelde teröristtir. Bir gecede 80 milyar Euroyu yok etmek bir terör eylemidir.”

Daha sonraki haberlerden ortaya çıkan tablo, yönetim kurulunun seçiminde YZ güvenliğiyle ilgili acil endişelerin değil, aksine Altman’a duyulan temel güvensizliğin belirleyici olduğu şeklinde. Wall Street Journal, “Altman’ı kovma kararının tek bir olaydan kaynaklanmadığını, aksine yönetim kurulu üyelerini giderek daha fazla huzursuz eden, zaman içinde yoğunlaşan, yavaş bir güven erozyonundan doğduğunu” tespit etti.

Altman’ın kovulmadan haftalar önce yönetim kurulu üyesi Helen Toner‘i, başkalarıyla birlikte yazdığı bir bir akademik makalede OpenAI’nin YZ güvenliği konusundaki kararlılığını eleştirmiş diye düşündüğü için, dürüst olmayan taktiklerle görevden almaya çalıştığı bildiriliyordu. EA’ya (Effective Altruists – Etkili Diğerkâmlar) yakın duran bir YZ yönetişim araştırmacısı olan Toner, makalede, “ChatGPT’nin piyasaya sürülmesinin teşvik eder göründüğü telaş içinde kestirme yola sapma eğiliminden kaçınması” nedeniyle Anthropic’ten övgü ile söz etmişti.

New Yorker’in haberine göre “kurulun altı üyesinden bazıları Altman’ı manipülatif ve sinsi olarak görüyorlardı”. Onun işten atılmasından birkaç gün sonra, daha önce OpenAI için çalışan bir DeepMind AI güvenlik araştırmacısı, Altman’ın “çeşitli vesilelerle kendisine yalan söylediğini” ve “başkalarına karşı aldatıcı, manipülatif ve kötü davrandığını” yazdı. Bu değerlendirme yakın tarihli bir Time dergisi haberinde de açığa vurulmuştu.

Altman’ın ilk kovuluşu bu değildi. 2019 yılında Y Combinator‘ın kurucusu Paul Graham, kendi çıkarlarını kuruluşun çıkarlarının önüne koymasından kaygı duyarak Altman’ı iş geliştirme merkezinin dümeninden uzaklaştırdı. Graham daha önce şöyle demişti: “Sam güç devşirme konusunda son derece başarılı.”

OpenAI’nin garip yönetim modeli, özellikle kâr amacı gütmenin yozlaştırıcı etkisini engellemek için tasarlandı, ancak The Atlantic dergisinin haklı olarak belirttiği gibi, “Para her zaman kazanır.” YZ yeteneklerinin geliştirilmesine de her zamankinden daha fazla para akmaktadır.

Tam yol ileri

YZ’deki son gelişmeler, on yıllardır süregelen birçok eğilimin doruğa ulaşmasıyla gerçekleşmiştir: (“Bilgi işlem” adı verilen) hesaplama gücündeki ve YZ modellerini eğitmek için kullanılan verilerdeki artışlar.. ki bunların kendileri de algoritmik verimlilikteki önemli iyileşmelerle büyütülmüştür. 2010 yılından bu yana YZ modellerini eğitmek için kullanılan bilgi işlem miktarı yaklaşık yüz milyon kat arttı. Bugün gördüğümüz ilerlemelerin çoğu, o zamanlar çok daha küçük ve yoksul olan bir alanın ürünüdür.

Her ne kadar geçtiğimiz yıl bu YZ tantanasında hak ettiğinin kesinlikle daha fazlasını almış olsa da, bu üç eğilimin bir araya gelmesi ölçülebilir sonuçlara yol açtı. YZ sistemlerinin birçok değerlendirme görevinde insan düzeyinde performansa ulaşması için gereken süre son on yılda önemli ölçüde kısaldı.

Yapay zekâ yeteneklerindeki artışın bir duvara çarpması elbette mümkün. Araştırmacıların kullanabilecekleri nitelikli veriler tükenebilir. Moore Yasası (bir mikroçipteki transistör sayısının her iki yılda bir ikiye katlandığı gözlemi) eninde sonunda tarih olacak. Siyasi olaylar üretim ve tedarik zincirlerini bozabilir ve bilgi işlem maliyetlerini artırabilir. Sistemlerin ölçeğini büyütmek de artık daha iyi performansa yol açmayabilir.

Ancak gerçek şu ki, mevcut yaklaşımların sahici sınırlarını kimse bilmiyor. Yann LeCun ile Ocak 2022’de yapılan bir söyleşinin. klibi bu yıl Twitter’da yeniden ortaya çıktı. LeCun şöyle diyordu: “Bir makineyi yalnızca metne dayanarak akıllı olacak şekilde eğitebileceğimizi sanmıyorum, çünkü bence metinde yer alan dünya hakkındaki bilgi miktarı, bilmemiz gerekenlere kıyasla çok az.”

Ne demek istediğini açıklamak için şöyle bir örnek verdi: “Bir nesneyi alıyorum, masanın üzerine koyuyorum ve masayı itiyorum. Nesnenin masa ile birlikte itildiği sizin için basbellidir. […] Ancak, metin tabanlı bir modelle bir makineyi eğitirseniz, ne kadar güçlü olursa olsun, ‘GPT-5000’iniz … bunu asla öğrenemeyecektir.”

Ancak ChatGPT-3.5’e bu örneği verdiğinizde kendisi anında doğru cevabı yapıştırıyor.

“Bezos’un ağzını sulandıran aynı insanlık dışı yetenekler, AGI’yi insanlar için de ölümcül bir tehdit haline getiriyor.”

İşten atılmasından dört gün önce yayınlanan bir söyleşide Altman şöyle demişti: “Bu modeli [GPT-5] eğitene kadar durum bizim için eğlenceli bir tahmin oyunu gibi. Bu konuda daha iyi olmaya çalışıyoruz, çünkü yeteneklerini tahmin etmenin güvenlik açısından önemli olduğunu düşünüyorum. Fakat size GPT-4’ün yapamadığı neyi yapacağını tam olarak söyleyemem.”

Tarih, icatların hızına ilişkin kötü tahminlerle doludur. Bir New York Times başyazısında, uçan bir makine geliştirmenin “bir milyon ila on milyon yıl” sürebileceği iddia edilmişti – Wright kardeşlerin ilk uçuşundan 69 gün önce. 1933’te, “nükleer fiziğin babası” Ernest Rutherford, nötronla tetiklenen bir zincirleme reaksiyon olasılığını kendinden emin bir şekilde dışladı ve fizikçi Leo Szilard’a hemen ertesi gün işe yarar bir çözüm varsayma konusunda ilham verdi – sonuçta bu, atom bombasının yaratılmasına temel olan bir çözümdü.

Şu sonuca varmaktan kaçınılması zor görünüyor: YZ sistemleri inşa etme konusunda en iyi olanlar, son zamanlarda, YGZ’nin (Yapay Genel Zeka / Artificial General Intelligence-AGI) hem mümkün hem de eli kulağında olduğuna inanmaktadır. Başı çeken iki YZ laboratuvarı, OpenAI ve DeepMind, belki de kuruluşlarından bu yana, herhangi bir yakın gelecekte bunu mümkün gördüğünüzü itiraf etseniz size gülünüp odadan atılabileceğiniz bir zamandan başlayarak, AGI için çalışıyorlardı (Ilya Sutskever, 2022’de OpenAI’nin tatil partisinde “AGI’yi Hisset” sloganına öncülük etmişti).

Mükemmel İşçiler

İşverenler halihazırda çalışanları gözetlemek, denetlemek ve sömürmek için YZ kullanıyor. Ancak asıl hayal, insanları döngünün dışına çıkarmak. Ne de olsa, Marx’ın yazdığı gibi, “Makine bir artı değer üretme aracıdır”.

Open Philanthropy‘den (OP) YZ risk araştırmacısı Ajeya Cotra bana “Maksimum düzeyde verimli bir kapitalist veya piyasa ekonomisinin mantıksal son noktasının” insanları içermeyeceğini, çünkü “insanların para kazanma konusunda çok verimsiz yaratıklar olduğunu” yazdı. Tüm bu “ticari açıdan verimsiz” duygulara değer veriyoruz, diye yazıyordu Cotra, ve ekliyordu, “dolayısıyla eğer iyi vakit geçirmiş olarak işi bitirir ve sonucu beğenirsek, bu, başlangıçta güce sahip olduğumuz ve sisteme insani değerlerle uyum sağlama doğrultusunda şekil verdiğimiz için olacaktır.”

OP, Facebook’un kurucu ortağı Dustin Moskovitz tarafından finanse edilen ve Etkili Diğerkâmlık‘tan (EA) ilham alan bir vakıftır. Birçoğundan bu makalede bahsedilen YZ güvenlik kuruluşlarının önde gelen fon sağlayıcısıdır. OP ayrıca, OpenAI’nin 2019’da kâr amacı güden bir kol oluşturmasından iki yıl önce, YZ güvenliği alanındaki çalışmalarını desteklemek için laboratuvara 30 milyon dolar bağışta bulunmuştur. Ben de daha önce, New York siyasetini ele alan ve kâr amacı gütmeyen bir araştırmacı haber kuruluşu olan New York Focus’taki yayıncılık çalışmalarını desteklemek için EA Funds’tan, ki o da OP tarafından finanse edilmektedir, bir kerelik bir hibe almıştım.

2017’de EA ile ilk kez temasa geçtikten sonra, gelirimin yüzde 10 ila 20’sini küresel sağlık alanında kâr amacı gütmeyen kuruluşlara ve fabrika çiftçiliği karşıtı kâr amacı gütmeyen kuruluşlara bağışlamaya başladım, yerel bir grup için gönüllü organizatör oldum ve küresel yoksulluğa karşı mücadele eden ve kâr amacı gütmeyen komşu bir kuruluşta çalıştım. YZ’den kaynaklanan varoluş riskini ciddi bir şekilde ele alan ilk topluluklardan biriydi EA; ancak sorunun belirsizliği ve şu anda yaşanan muazzam, önlenebilir acılar göz önüne alındığında, YZ takımına biraz ihtiyatla baktım.

İtaatkâr bir AGI, kapitalistlerin yalnızca hayal edebileceği türden, yorulmak bilmez, motive olmuş ve tuvalet molalarına ihtiyacı duymayan bir işçi olacaktır. Frederick Taylor‘dan Jeff Bezos’a kadar yöneticiler, insanların ürün çıktısı için optimize edilmediği ve dolayısıyla işverenlerinin kırmızı çizgisi olan çeşitli yollara içerlemektedir. Taylor’ın bilimsel yönetiminin ortaya çıktığı günlerden önce bile, sanayi kapitalizmi, işçileri birlikte çalıştıkları ve giderek onların yerini alan makinelere daha çok benzetmeye çalışıyordu. Komünist Manifesto’nun öngörüyle gözlemlediği gibi, kapitalistlerin yaygın makine kullanımı işçiyi “makinenin bir uzantısı” haline getirir.

Fakat YZ güvenlik topluluğuna göre, Bezos’un ağzını sulandıracak olan tam da bu aynı insanlık dışı yetenekler AGI’yi insanlar için ölümcül bir tehdit haline de getiriyor.

Patlama: Yok Oluş Vakası

Yaygın X-Risk argümanı şöyledir: YZ sistemleri belirli bir eşiğe ulaştığında bir “zekâ patlaması” tetikleyip kendilerini tekrar tekrar geliştirebiecektir. Yeni bir YZ sistemi yeterince akıllı hale gelirse -ya da sadece ölçek büyütürse – insanlığı kalıcı olarak güçsüzleştirebilir.

Ekim 2023’te yayınlanan ” YZ Risklerini Yönetmek” başlıklı makale şunu belirtiyor:

“YZ ilerlemesinin insan düzeyindeki yeteneklere ulaştığında yavaşlaması veya durması için hiçbir temel neden yok. […] İnsanlarla karşılaştırıldığında YZ sistemleri daha hızlı hareket edebilir, daha fazla bilgiyi özümseyebilir ve çok daha yüksek bant genişliğiyle iletişim kurabilir. Ayrıca sınırsız bilgi işlem kaynağı kullanacak şekilde ölçeklendirilebilir ve milyonlarca kez kopyalanabilirler.”

Bu özellikler daha şimdiden insanüstü yetenekleri mümkün kılmıştır: LLM‘ler internetin büyük bir kısmını aylar içinde “okuyabilir” ve DeepMind’ın AlphaFold’u insanların yıllarca süren laboratuvar çalışmalarını birkaç gün içinde gerçekleştirebilir.

İşte “nüfus” artışının bir zekâ patlamasını tetikleyeceği iddiasının stilize edilmiş bir sürümü: YZ sistemleri araştırma ve geliştirmede bilim insanlarına rakip olursa, sistemler hızla çoğalacak ve ekonomiye muazzam sayıda yeni, yüksek üretkenlikte işgücünün girmesine yol açacaktır. Başka bir deyişle, GPT-7 bir insan işçinin görevlerinin çoğunu yerine getirebilirse ve eğitilmiş modeli bir günlük görev üzerine çalıştırmak yalnızca birkaç dolara mal olursa, modelin her bir örneği pozitif bir geri besleme döngüsü başlatarak çılgınca kârlı olacaktır. Bu da, her biri onları çalıştırmak için gereken enerjinin maliyetinden çok daha yüksek değere sahip milyarlarca ya da daha fazla dijital çalışanın oluşturduğu sanal bir “nüfusa” yol açabilir. Sutskever, “dünyanın tüm yüzeyinin güneş panelleri ve veri merkezleriyle kaplanmasının” muhtemel olduğunu düşünüyor.

Bir araştırmacı, güvenlik testleri sırasında bir yapay zeka modelinin tanınmamak için “ölü taklidi yaptığını” keşfettiğinde şaşkına döndü.

Bu dijital işçiler bizim YZ tasarımlarımızı geliştirebilir ve Alan Turing‘in 1951’de akıl yürüttüğü gibi, yetenekleri yakında “cılız güçlerimizi aşacak” olan “süper zeki” sistemlere doğru kendi başlarına ilerleyebilirler. Üstelik, bazı yapay zekâ güvenliği savunucularının öne sürdüğü gibi, tek bir yapay zekâ modelinin varoluşsal tehdit oluşturması için süper zeki olması gerekmiyor; sadece yeterli sayıda kopyasının bulunması bile yetebilir. Kaynaklarımın çoğu, şirketleri, yetenekleri kendilerini oluşturan üyelerin yeteneklerinden açıkça ileri geçen süper zekalara benzetti.

“Sadece fişi çekin” diye yaygın bir itiraz var. Ancak bir yapay zekâ modeli insanlığı tehdit edecek kadar güçlendiğinde muhtemelen mevcut bulunlan en değerli şey olacaktır. New York Menkul Kıymetler Borsası’nın veya Amazon Web Hizmetlerinin “fişini çekmek” belki nispeten daha kolay olabilir.

Tembel bir süper zekâ çok fazla risk oluşturmayabilir ve Allen Institute for AI (Allen YZ Enstitüsü) CEO’su Oren Etzioni, Karmaşıklık profesörü Melanie Mitchell ve AI Now Institute (YZ Şimdi Enstitüsü) genel müdürü Sarah Myers West gibi şüphecilerin hepsi, bana, YZ sistemlerinin giderek daha özerk hale geldiğine ilişkin ikna edici kanıt görmediklerini söyledi. Anthropic’ten Dario Amodei de, mevcut sistemlerin kaygı verici düzeyde bir eylemlilik sergilemediği konusunda hemfikir görünüyor. Bununla birlikte, kötü bir aktörün emrinde olan tamamen pasif ama yeterince güçlü bir sistem de Bengio gibi insanları endişelendirmek için yeterlidir.

Dahası, hem akademisyenler hem de sanayiciler YZ modellerini daha özerk hale getirmek için çabalarını artırıyor. Altman, görevden alınmadan birkaç gün önce Financial Times’a şunları söyledi: “Bu aracıları gittikçe daha güçlü hale getireceğiz […] ve bundan sonra eylemler gitgide daha karmaşık hale gelecek. […] Bunu her kategoride yapabilmenin getirdiği iş değeri, bence, oldukça iyi.”

Bu tantananın arkasında ne var?

Birçok X-Risk insanını geceleri uykusuz bırakan korku, gelişmiş birYZ’nin “uyanması”, “şeytana dönüşmesi” ve kötü niyetle herkesi öldürmeye karar vermesi değil, daha ziyade sahip olduğu şu veya bu hedef için bizi bir engel olarak görmeye başlamasıdır. Ünlü fizikçi Stephen Hawking, Büyük Sorulara Kısa Yanıtlar adlı son kitabında bu durumu şöyle ifade etmişti: “Siz muhtemelen karıncalardan nefret eden ve kasten onların üstüne basan biri değilsinizdir. Ancak bir hidroelektrik yeşil enerji projesinden sorumluysanız ve suya gömülecek olan bölgede bir karınca yuvası varsa, bu, karıncalar için çok kötü olacaktır.“

Beklenmedik ve istenmedik davranışlar, ister kâr ister YZ’nin ödül işlevi olsun, basit hedeflerden ileri gelebilir. Bir “Serbest” piyasada kâr arayışı tekellere, çok katmanlı pazarlama entrikalarına, havanın ve nehirlerin zehirlenmesine ve sayısız başka zarara yol açar.

Şaşırtıcı ve istenmedik davranışlar sergileyen YZ sistemlerinin bolca örneği var. Bir listedeki sıralama hatalarını ortadan kaldırması beklenen bir program listeyi tamamen silmişti. Bir araştırmacı, güvenlik testleri sırasında bir yapay zeka modelinin tanınmamak için “ölü taklidi yaptığını” keşfettiğinde şaşkına döndü.

Başkaları ise bu endişelerin arkasında bir Büyük Teknoloji (Big Tech) komplosunun yattığını düşünüyor. YZ’nin acil zararlarına odaklananların bazıları, sektörün, ürünlerinin dünyanın sonunu getirebileceği fikrini aktif olarak desteklediğini ileri sürüyor. Örneğin AI Now Enstitüsü’nden Sarah Myers West, “Sözde varoluşsal risk anlatılarını, şu anda anlamlı bir hareket olmamasını sağlamak için ogerçekten odadaki tüm havayı boşaltmaya yönelik bir oyun olarak gördüğünü” söylüyor. Garip bir şekilde Yann LeCun ve Baidu AI‘nin baş bilim adamı Andrew Ng de onunla aynı fikirde gibi görünüyor.

Bu fikri x-riskine inananlara aktardığımda, genellikle şaşkınlık ve kızgınlık karışımı bir tepki gösterdiler. OP’den Ajeya Cotra şöyle cevap yazdı: “Keşke varoluşsal riskle hakkındaki endişe endüstriyle daha az bağlantılı bir şey olsaydı, çünkü bunun tam olarak temelden, esasa dair, çok endüstri karşıtı bir inanç olduğunu düşünüyorum. […] Eğer şirketler hepimizi öldürecek şeyler inşa ediyorlarsa, bu gerçekten kötüdür ve yasalarca çok sıkı bir şekilde kısıtlanmaları gerekir. “

GovAI’den Markus Anderljung, düzenleyici tuzak korkularını “insanların doğal bir tepkisi” olarak tanımladı, ancak tercih ettiği politikaların sektördeki en büyük oyunculara pekala zarar verebileceğini de vurguladı.

Güvensizliğin anlaşılır bir nedeni, Sam Altman’ın günümüzde varoluşsal risk fikriyle en çok ilişkilendirilen insanlardan biri olması, fakat şirketinin genel amaçlı YZ sınırlarını zorlamak için diğerlerinden daha fazlasını yapmasıdır.

Buna ek olarak, OpenAI daha kârlı hale geldikçe ve Altman da iktidara yaklaştıkça CEO kamusal söylemini değiştirdi. Ocak 2023’teki bir soru-cevap faslında, kendisinin en kötü YZ senaryosu sorulunca, “Hepimiz için ışıklar söner” diye karşılık vermişti. Ancak dört ay sonra, Mayıs’ta, bir ABD Senato komitesi önünde yeminli olarak benzer bir soruyu cevaplarken yok oluştan hiç söz etmedi. Muhtemelen işten çıkarılmadan önceki son röportajında ise şunları söyledi: “Hepimizin yok olacağını gerçekten düşünmüyorum. Bence harika olacak. Bence gelmiş geçmiş en iyi dünyaya doğru ilerliyoruz.”

Altman, Mayıs 2023’te ABD Kongresi’ne yapay zekâ endüstrisini düzenlemesi için yalvarmıştı, ancak Kasım ayındaki bir soruşturma ortaya çıkardı ki, OpenAI’nin sanki ana şirketi gibi olan Microsoft, ChatGPT gibi temel modellerin yakında çıkacak Avrupa Birliği YZ yasasındaki düzenlemelerin dışında bırakılmasına yönelik ama sonuçta başarısız bir lobicilik çabasında etkili olmuştu . Altman’ın kendisi de AB’de epey lobi faaliyeti yürüttü; hatta düzenlemelerin çok kısıtlayıcı olması halinde bölgeden çekilme tehdidinde bulundu (bu tehdidini kısa sürede geri çekti). Görevden alınmasından birkaç gün önce San Francisco’daki bir CEO panelinde Altman şunları söylemişti: “Mevcut modeller gayet iyi. Burada güçlü düzenlemelere ihtiyacımız yok. Muhtemelen gelecek birkaç nesil için bile.”

Başkan Biden’in YZ üzerine son “geniş kapsamlı” idari kararnamesi de hemfikir görünüyor: Güvenlik testlerine ilişkin bilgi paylaşım gereklilikleri yalnızca şimdiye kadar eğitilmiş olması muhtemel bulunanlardan daha büyük modelleri etkiliyor. Myers West, bu tür “ölçek eşiklerini” bir “iri kıyım ayırma” olarak niteledi. Anderljung bana yazdığı mektupta düzenlemenin bir sistemin yetenekleri ve kullanımıyla ölçeklendirilmesi gerektiğini belirtti, ve, “günümüzün en yetenekli ve yaygın kullanımdaki modellerine yönelik bazı düzenlemeleri memnuniyetle karşılayacağını” ancak “henüz geliştirilmemiş sistemlere gerekler dayatmanın politik olarak çok daha uygulanabilir olacağına inandığını” söyledi.

Inioluwa Deborah Raji, teknoloji devlerinin “bir dereceye kadar kötü adam olmaları gerektiğini bilirlerse, bunun soyut ve zaman akışında uzun vadeli olmasını tercih edeceklerini” ileri sürdü. Bu bana, Büyük Teknoloji’nin aslında kendi ürünlerinin herkesi tam anlamıyla öldürmek için yeterli şansına sahip olduğu fikrine destek olmak istemesi fikrinden çok daha makul geliyor.. Bu bana, , ürünlerinin tüm insanları gerçekten yok etme şansının yüksek olduğu fikrini güçlendirmek istediği fikrinden çok daha makul geliyor.

Yok oluş mektubunu çoğu akademisyen olmak üzere yaklaşık 700 kişi imzaladı. Bu kişilerden yalnızca biri borsada işlem gören bir şirketi yönetiyor: OP fon sağlayıcısı Moskovitz; aynı zamanda bir verimlilik uygulaması olan Asana‘nın kurucu ortağı ve CEO’su. Amazon, Apple, IBM ya da diğer önde gelen YZ donanım üreticilerinden hiç kimse yoktu. Hiçbir Meta yöneticisi de imza atmadı.

Eğer Büyük Teknoloji firmalarının yöneticilerinin yok oluş anlatısını güçlendirmek istedikleri doğruysa, neden kendi isimlerini listeye eklemediler?

Neden bir “kıyamet günü makinesi” inşa edilsin?

Eğer YZ gerçekten dünyayı kurtarırsa, onu geliştiren kişi modern bir Jül Sezar gibi övülmeyi umabilir. Kurtarmasa bile, “insanoğlunun yapması gereken son icadı” ilk yapanın, her kim olursa olsun, tarih tarafından unutulmaktan korkmasına gerek kalmayacaktır – tabii ki bu icattan sonra tarih aniden sona ermezse.

Connor Leahy, şu anki yörüngemizde tarihin sonunun AGI’nin ortaya çıkışından kısa bir süre sonra geleceğine inanıyor. Dalgalanan saçları ve bakımsız keçi sakalıyla, ola ki kendi sahasında ve üzerine “kıyamete az kaldı” yazılı ilan panosu geçirmiş birine benzeyecektir; ancak bu onun Ingiliz Lordlar Kamarası’na veya CNN’e konuşmacı olarak davet edilmesine engel olmadı. Conjecture‘un 28 yaşındaki CEO’su ve etkili bir açık kaynak kolektifi olan EleutherAI‘nin kurucu ortağı, bana, YZ geliştirme motivasyonunun çoğunun şunlardan ibaret olduğunu söyledi: “‘Ha, sana milyarlarca dolar kazandıracak ve seni dünyanın hükümdarı yapacak ya da herkesi öldürecek nihai kıyamet makinesini mi inşa ediyorsun?’ Evet, erkeklerin en büyük hayali gibi bu Sen şunu söylüyorsun: ‘Kahretsin, aynen öyle. Ben kıyametin kralıyım.’« Şöyle devam ediyor: “Anlıyorum. Bu, Silikon Vadisi estetiğine çok iyi uyuyor.”

Leahy ayrıca (San Francisco) Körfez Bölgesi’nde ya da İnternet’in belirli köşelerinde fazlaca zaman geçirmiş olanları şaşırtmayacak bir şey de aktardı: “Çoğunlukla San Francisco’da yaşayan ve sırf kendileri sonsuza kadar yaşama şansına sahip olabilecekleri için sizin, çocuklarınızın, torunlarınızın ve gelecekteki tüm insanlığın hayatını riske atmaya hazır olan, gerçek, hesap vermekten tamamen azade, seçilmemiş, tekno-ütopyacı iş insanları ve teknoloji uzmanları var.”

MIT Technology Review 2023 Mart ayında Altman’dan haber verdi. “Kendisi diyor ki, şu iki amacını finanse etmek için banka hesabını boşaltmış: Sınırsız enerji ve uzatılmış ömür.”

Bütün bunlar göz önüne alındığında, etik topluluğunun, kendi başlarına riskli ve zararlı ürünler geliştiren ve hesap sorulamayan teknoloji seçkinlerini dizginlemek için ortak mücadelede, güvenlik topluluğunu doğal bir müttefik olarak görmesini bekleyebilirsiniz. Daha önce de gördüğümüz gibi, birçok güvenlik savunucusu zaten YZ etikçilerine doğru adım atttı. X-Risk topluluğundaki kişilerin YZ etiğine alenen saldırması da nadirdir (bunun tersi… doğru olmasa da), ancak gerçek şu ki güvenlik savunucuları bazen çekilmez oluyor.

“Yapay zekâyı düzenlemeye yönelik çabalara verilen en yaygın tepkilerden biri ‘ama Çin’ itirazıdır.”

YZ etikçileri, savundukları insanlar gibi, kendilerini genellikle dışlanmış ve gerçek güçten yoksun hissettiklerini ve onları sahici bir öncelikten ziyade kıçlarını örtmenin bir yolu olarak gören teknoloji şirketleriyle çetin bir savaş vermek zorunda kaldıklarını bildirmektedir. Son yıllarda (ya da günlerde) birçok Büyük Teknoloji şirketinde yapay zeka etik ekiplerinin içinin boşaltılması da bu hissi destekliyor. Ve bazı durumlarda, Bu şirketler bir dizi olayda etik-odaklı ihbarcılara (whistleblowers) ve emek örgütleyicilerine karşı misillemede bulundular.

Bu durum, söz konusu şirketlerin varoluşsal riske ciddi bir şekilde öncelik verdikleri anlamına gelmiyor. Larry Page ve önde gelen X-Risk araştırmacısı Toby Ord‘un da içinde olduğu Google DeepMind etik kurulu ilk kez 2015’te toplandı ancak ikinci bir toplantı hiçbir zaman yapılmadı. Google’dan bir YZ araştırmacısı bana “ofiste uzun vadeli riskler hakkında konuşmadıklarını” yazdı ve şöyle devam etti: “Google daha çok teknolojiyi geliştirmeye, güvenlik bakımından da yasallık ve saldırganlığa odaklanmış durumda.”

Yazılım mühendisi Timnit Gebru, bir makale taslağı üzerine çıkan anlaşmazlığın ardından 2020’nin sonlarında şirketten ayrılmaya zorlanana kadar, Google’daki etik YZ ekibini yönetti – ki o metin şu anda makine öğrenimi hakkındaki gelmiş geçmiş en ünlü yayınlarından biri. “Stokastik Papağanlar” (Stochastic Parrots) başlıklı makalede Gebru ve ortak yazarları, LLM’lerin çevreye zarar verdiğini, toplumsal önyargıları güçlendirdiğini ve “anlamla herhangi bir bağlantısı olmaksızın” dili “gelişigüzel” bir araya getirmek için istatistikleri kullandığını öne sürüyor.

YZ güvenlik topluluğunun hayranı olmayan Gebru, GovAI”nin beyaz kitabındaki temel önerilerden biri olan YZ araştırmacıları arasında bilgi uçuranların (Whistleblower) korunmasını iyileştirme çağrısında bulundu. Gebru’nun Google’dan kovulmasından bu yana, yaklaşık 2.700 çalışan bir dayanışma mektubu imzaladı, ancak o zamanki Google çalışanı Geoff Hinton aralarında değildi. CNN tarafından kendisine ihbarcı meslektaşını neden desteklemediği sorulan Hinton, Gebru’nun YZ’ye yönelik eleştirilerinin kendisininkinden “tamamen farklı kaygılarla” ilgili olduğunu ve “bu şeylerin bizden daha akıllı olacağı ve yönetimi ele alacağı fikri kadar varoluşsal bakımdan tehlikeli olmadığını” söyledi.

Raji bana etik ve güvenlik toplulukları arasındaki “hayal kırıklığı ve husumetin çoğunun” “bir tarafın diğerinden çok daha fazla paraya ve güce sahip olmasından” ve bunun da “gündemlerini çok daha doğrudan dayatmalarına olanak sağlamasından” kaynaklandığını söyledi.

Bir tahmine göre, YZ güvenliği ile ilgili yeni şirket girişimlerine (start-ups) ve kâr amacı gütmeyen kuruluşlara akan para miktarı 2020’den 22’ye kadar dört katına çıkarak 144 milyon dolara ulaşmış. Yapay zekâ etik topluluğu için eşdeğer bir sayı bulmak zor. Bununla birlikte her iki kamptan sivil toplum sanayi harcamalarının yanında cüce kalıyor. OpenSecrets, 2023’ün sadece ilk çeyreğinde ABD’de YZ lobiciliği için yaklaşık 94 milyon dolar harcandığını bildirdi. LobbyControl, teknoloji şirketlerinin geçen yıl AB’de lobi faaliyeti için 113 milyon Avro harcadığını tahmin ediyordu. Biz konuşurken YZ endüstrisine yüz milyarlarca dolar yatırım yapıldığı da tekrar aklımıza gelecek.

Düşmanlığı, algılanan herhangi bir güç ve para farkından daha fazla körükleyen bir şey de eğilim çizgisidir. Veri bilimci Cathy O’Neil‘in yazdığı 2016 tarihli Weapons of Math Destruction (Matematik İmha Silahları) gibi büyük beğeni toplayan kitapların, Buolamwini ve Gebru’nun 2018 tarihli “Gender Shades” (Cinsiyet Gölgesi) makalesi gibi algoritmik önyargıya ilişkin çığır açan keşiflerin ardından, YZ etiği perspektifi kamuoyunun dikkat ve desteğini kazanmıştı.

2014 yılında, YZ x-risk davası filozof Nick Bostrom’un yazdığı Süperzekâ ile çok satan sürpriz bir kitaba sahip oldu. Elon Musk ve Bill Gates gibi şahıslar tarafından övülen bu kitap, insanı aşan YZ’nin yok oluşa götürebileceğini savunmaktadır. Ancak Yudkowsky bana ChatGPT öncesinde, kitabın tezini ciddiye almanın Silikon Vadisi’ndeki belli çevreler dışında insanların sizi gülünç bulmasına neden olacağını söyledi. Yudkowsky gibi erken dönem YZ güvenliği savunucuları, daha geniş söylemde marjinal kalmaya devam ederken, San Francisco Körfez Bölgesi’nin teknoloji kurtları (Bay-Area-Techies) aracılığıyla zenginlik ve güçle yakın bağlar geliştirmek gibi garip bir konumda yer aldılar.

ChatGPT sonrası dünyada Turing ve Nobel Ödülü sahipleri YZ güvenliği dolabından çıkıyor ve en iyi bilinen yayını 660.000 kelimeden fazla Harry Potter hayran kurgusu olan Yudkowsky’nin popüler hale getirdiği argümanları benimsiyor.

Belki de bu yeni dünyanın en şok edici alameti, geçen Kasım ayında, New York Times’ın teknoloji podcast’i Hard Fork’un sunucularının ABD Ticaret Komisyonu Başkanı’na Lina Khan‘a şu soruyu sorduğu zaman yayınlandı: ““Sizin p(doom)’unuz nedir, Lina Khan? YZ’nin hepimizi öldürme olasılığı nedir?” EA su soğutucu konuşması artık herkesin dilinde (Khan kendisinin “iyimser” olduğunu söyledi ve yüzde 15’lik “düşük” bir tahmin verdi).

Tüm açık mektuplar ve medya çevrimleri göz önüne alındığında, YZ araştırmacılarının çoğunluğunun varoluşsal riske karşı harekete geçeceğini düşünmek kolay olurdu. Ancak Bengio’ya X-Risk’in bugün makine öğrenimi topluluğunda (machine learning community) nasıl algılandığını sorduğumda şöyle dedi: “Ah, çok değişti. Daha önce insanların yaklaşık yüzde 0,1’i bu sorunla ilgileniyordu. Şimdi belki yüzde 5’tir.”

Olasılıklar

YZ’nin nın ortaya çıkardığı varoluşsal riskten endişe duyan pek çok kişi gibi ünlü zihin felsefecisi David Chalmers da sohbetimiz sırasında bir olasılık argümanı öne sürdü: “Bu, kaygılanmak için insan düzeyinde bir YZ’ye sahip olunacağından yüzde 100 emin olmanız gereken bir durum değil. Eğer yüzde 5 bile olsa, kaygı duymalıyız.”

Bu istatistiksel düşünme tarzı EA topluluğunda çok popülerdir ve üyelerini ilk etapta YZ ile ilgilenmeye iten şeyin büyük bir kısmıdır. Eğer uzman görüşlerine itibar ederseniz, sonuçta kafanız daha da karışabilir. Bununla birlikte, bir bir avuç anketten uzmanların endişelerinin ortalamasını almaya çalışırsanız, YZ nedeniyle yok olma olasılığının en az yüzde birkaç olduğu sonucuna varabilirsiniz, ki bu da onu dünyadaki en önemli şey haline getirmek için yeterli olabilir. Eğer var olabilecek tüm gelecek nesillere de herhangi bir değer biçerseniz, insan soyunun tükenmesi kategorik olarak hayatta kalınabilir felaketlerden daha kötüdür.

“Belli bir noktada, siyaset felsefesinin tüm sorularına geri dönüyoruz: Gerçekte ne tür bir toplum istiyor ve buna değer veriyoruz?“

Ancak YZ tartışmaları kibirli olma suçlamalarıyla dolu. Melanie Mitchell ve Oren Etzioni gibi şüpheciler bana X-Risk davasını destekleyecek kanıt olmadığını söylerken, Bengio ve Leahy gibi X-Risk’çiler yapay zekânın şaşırtıcı yetenek kazanımların işaret ederek soruyorlar: Ya ilerleme durmazsa? Akademik YZ araştırmacısı bir arkadaşım, AGI’nin ortaya çıkışını küresel ekonomi ve siyaseti bir miksere atmaya benzetti.

Herhangi bir nedenle AGI insan zekâsıyla eşleşse ve onu geçemese bile, sayıları neredeyse keyfi olarak çoğalacak insan düzeyindeki dijital aracılarla dünyayı paylaşma ihtimali dehşet vericidir – özellikle de bunların muhtemelen birilerine para kazandırmaya çalışacakları düşünüldüğünde.

YZ’den kaynaklanan varoluş riskinin nasıl azaltılacağına dair burada tartışılamayacak kadar çok politika fikri var. Ancak YZ güvenlik topluluğundan gelen en net mesajlardan biri “yavaşlamamız” gerektiğidir. Böyle bir hız kesmenin savunucuları, bunun politik sorumlulara ve daha geniş topluma aradaki mesafeyi kapatma, potansiyel olarak dönüştürücü bir teknolojinin nasıl geliştirilmesi ve kullanılması gerektiğine aktif olarak karar verme şansı tanıyacağını umuyor.

Uluslararası işbirliği

YZ’yi düzenleme çabalarına verilen en yaygın tepkilerden biri “ama Çin!” itirazıdır. Örneğin Altman, Mayıs ayında Senato komisyonuna “Amerika’nın liderliği ele geçirmesini istiyoruz” dedi ve gelişmeyi yavaşlatma riskinin “Çin veya başka birinin daha hızlı ilerleme kaydetmesi” anlamına geldiğini açıkladı. Öte yandan Anderljung bana bunun “YZ’yi düzenlememek için yeterince iyi bir neden olmadığını” yazdı.

Haziran 2023’te Foreign Affairs’de yayınlanan bir makalede Helen Toner, Jenny Xiao ve Jeffrey Ding, görüştükleri Çinli YZ araştırmacılarının Çin’deki LLM’lerin ABD’deki en son modellerin en az iki ila üç yıl gerisinde olduğuna inandıklarını bildiriyor.Ayrıca makaleyi yazanlar, Çin’in YZ alanındaki ilerlemesinin “büyük ölçüde yurt dışında yayınlanan araştırma sonuçlarının yeniden üretilmesi ve optimize edilmesine dayandığını” ve tek taraflı bir yavaşlamanın “muhtemelen Çin’in ilerlemesini de yavaşlatacağını” savunuyorlar. Çin ayrıca, Anthropic’in politik alanından sorumlu Jack Clark’ın gözlemlediği gibi, YZ’yi anlamlı bir şekilde diğer tüm büyük ülkelerden daha hızlı düzenlemeye başladı.

Yudkowsky şöyle diyor: “İnsanlığın geri kalanıyla birlikte intihar etmek aslında Çin’in çıkarına değil.”

Eğer gelişmiş YZ gerçekten tüm dünyayı tehdit ediyorsa, ulusal düzenlemeler tek başına yeterli olmayacaktır. Ancak güçlü ulusal kısıtlamalar, diğer ülkelere riskleri ne kadar ciddiye aldığınıza dair inandırıcı bir sinyal verebilir. Tanınmış YZ etik uzmanı Rumman Chowdhury küresel gözetim çağrısında bulundu. Bengio “her ikisini de yapmak zorundayız” diyor.

Yudkowsky, şaşırtıcı olmayan bir şekilde, keskin bir tutum benimsedi ve bana şunları söyledi: “Doğru yön, simetrik bir sözleşmeye sahip kurullar tarafından tüm yapay zekâ donanımlarını uluslararası gözetim altındaki sınırlı sayıda veri merkezine yerleştirmek gibi görünüyor; böylece ordu, hükümetler, Çin veya CIA dahil hiç kimse, süper zekâlar inşa etmeyi de içeren gerçekten korkunç şeylerin hiçbirini yapamaz.”

Mart 2023’te Time degisindeki tartışmalı bir yazısında Yudkowsky, askeri güç tehdidiyle desteklenen “yeni büyük eğitim denemeleri” için uluslararası bir moratoryum oluşturup “her şeyi durdurmayı” savundu. Yudkowsky’nin gelişmiş YZ’nin herhangi bir nükleer veya biyolojik silahtan çok daha tehlikeli olacağına dair güçlü inancı göz önüne alındığında, bu radikal duruş da doğal olarak peşinden gelir.

Son YZ Güvenlik Zirvesi’ndeki 28 ülkenin tamamı, ABD ve Çin de dahil olmak üzere, Bletchley Deklarasyonu’nu imzalamış durumda. Buna göre, YZ’den kaynaklanan mevcut zararlar ile “potansiyel kasıtlı kötüye kullanımdan veya insan niyetiyle uyumlu olmaya ilişkin istenmedik kontrol sorunlarından önemli riskler doğabileceği” gerçeği kabul edilmektedir.

Zirvede, ev sahibi İngiliz hükümeti, Hükümetlerarası İklim Değişikliği Paneline (IPCC) benzer kalıcı bir uzman kuruluşa doğru önemli bir adım olarak, Bengio’yu “çığır açan YZ’nin yetenekleri ve riskleri” hakkında ilk “Bilimin Durumu” (State of the Science) – raporunun hazırlanmasına öncülük etmekle görevlendirdi.

YZ’nin gelişmesi konusunda anlamlı bir uluslararası koordinasyon için ABD ile Çin arasında işbirliği, yapay zekâ gelişiminin etkili uluslararası koordinasyonu için zorunlu olacaktır. YZ söz konusu olduğunda iki ülkenin arası pek de iyi değil. ABD, 2022 Çip Yasası’nın (2022 CHIPS Act) ihracat kontrolleriyle Çin’in yapay zekâ yeteneklerine diz çöktürmeye çalıştı; ki bu, bir endüstri analistinin daha önce “savaş eylemi” olarak değerlendirebileceği bir şeydi. Jacobin’in Mayıs ayında bildirdiği gibi, bazı X-Risk odaklı siyasi araştırmacılar zahmetli denetimlerin geçirilmesinde muhtemelen bir rol oynadı. Ekim ayında ABD, gedikleri kapatmak için Çip Yasası kısıtlamalarını sıkılaştırdı.

Bununla birlikte cesaret verici bir işaret olarak Biden ve Xi Jinping Kasım ayında YZ güvenliğini ve ölümcül silah sistemlerinde YZ’nin yasaklanmasını görüştüler. Beyaz Saray’dan yapılan bir basın açıklamasında şöyle deniyordu: “Liderler ABD-Çin hükümet görüşmeleri yoluyla gelişmiş YZ sistemlerinin risklerini ele alma ve YZ güvenliğini iyileştirme ihtiyacını teyit ettiler.”

Öldürücül özerk silahlar (lethal autonomous weapons-LAWs) da YZ tartışmalarında göreceli bir anlaşma alanıdır. Joy Buolamwini, Unmasking AI: My Mission to Protection What Is Human in a World of Machines‘de (YZ’nin Maskesini Düşürmek: Makineler Dünyasında İnsan Olanı Koruma Görevim) adlı yeni kitabında, birçokYZ güvenlik savunucusunun epeydir süregelen endişesini tekrar ederek, “Katil Robotları Durdur” kampanyasını destekliyor. Bir X-Risk kuruluşu olan Hayatın Geleceği Enstitüsü (Future of Life Institute), 2016 yılında, Bengio, Hinton, Sutton, Etzioni, LeCun, Musk, Hawking ve Noam Chomsky’nin de aralarında bulunduğu ideolojik olarak birbirine muhalif kişileri, saldırgan LAWs’un yasaklanması çağrısında bulunan bir açık mektup imzalamak üzere bir araya getirdi.

Müzakere masasında bir koltuk

Yıllarca süren eylemsizliğin ardından, dünya hükümetleri nihayet dikkatlerini YZ’ye çeviriyor. Ancak sosyalistler gelecekteki sistemlerin neler yapabileceğiyle ciddi bir şekilde ilgilenmeyerek masadaki yerlerini terk ediyorlar.

X-Risk fikrini ciddi olarak ilk benimseyenlerin çoğu, YZ’nin cazibesine hiç de küçümsenemeyecek ölçüde kapılan tipten insanlar oldukları için, ya gelişmiş YZ’yi nasıl kontrol edeceklerine dair son derece teorik araştırmalara girişme kararı verdi veya yapay zekâ şirketleri kurdu. Ancak farklı tipten bir kişi için, YZ’nin dünyanın sonunu getirebileceğine inanmanın karşılığı, insanları onu inşa etmekten vaz geçirmeye çalışmaktır.

“YZ destekçileri” YZ gelişiminin kaçınılmaz olduğunu söyleyip duruyorlar – ve eğer yeterince insan inanırsa, bu gerçek oluyor. Ancak AI Now Enstitüsü, “yapay zeka ile ilgili kaçınılmaz olan hiçbir şey yok” diye yazıyor. CEO Myers West bunu doğruluyor ve yüz tanıma teknolojisinin 2018’de kaçınılmaz göründüğünü, ancak o zamandan beri birçok yerde yasaklandığını belirtiyor. X-Risk araştırmacısı Katja Grace‘in de işaret ettiği gibi, sadece yapabildiğimiz için her teknolojiyi inşa etme ihtiyacı hissetmemeliyiz.

Buna ek olarak, birçok politika belirleyici son zamanlardaki yapay zekâ gelişmelerine bakıyor ve küplere biniyor. Senatör Mitt Romney YZ konusunda iyimser olmaktan çok “dehşete düşmüş durumda” ve meslektaşı Chris Murphy “Bu kadar çok insan işlevinin YZ’ye devredilmesinin sonuçları potansiyel olarak felaket” diyor. Demokrat Kongre üyesi Ted Lieu ve Cumhuriyetçi Kongre Başkanı Mike Johnson ise YZ karşısında kelimenin tam anlamıyla “çılgına dönmüş”ler. YZ’nin yeteneklerinin önemli ölçüde geliştiğini ve gelecekte tür-düzeyinde bir tehdit oluşturabileceğini kabul etmeye istekli kişiler yalnızca bazı teknoloji uzmanlarıysa, politika yapıcılar orantısız bir şekilde onları dinleyecektir. Mayıs ayında profesör ve yapay zekâ etikçisi Kristian Lum şöyle bir tweet attı: “Eminin “LLM’lerin oluşturduğu bir varoluş riski var ve bu, onlar hakkında yılan yağı anlatısını (yalan haber, aldatmaca) zorlamaya devam edersek, FAccT [Adillik, Hesap Verebilirlik ve Şeffaflık] / Etik YZ alanının güvenilirliği içindir.

YZ kaynaklı yok oluş fikri size bilimden ziyade kurgu gibi görünse bile, dönüştürücü bir teknolojinin nasıl geliştirileceği ve hangi değerleri temsil edeceği üzerinde muazzam bir etki yaratabilir. Varsayımsal bir AGI’ye istediğimiz her şeyi yaptırabileceğimizi göz önüne alırsak, belki de insanlığın karşılaşacağı en önemli soruyu gündeme getirmiş oluruz: Onun ne istemesini istemeliyiz?

Chalmers’a bunu sorduğumda şöyle dedi: “Belli bir noktada siyaset felsefesinin tüm sorularını yeniden özetlemiş oluyoruz: Gerçekten istediğimiz ve gerçekten değer verdiğimiz toplum ne tür bir toplumdur?”

“Bazılarımız risklerin tamamen farkında ve yine de devam ediyorlar.”

İnsan seviyesindeki YZ’nin ortaya çıkışını düşünmenin bir yolu, bunun yeni bir ülkenin anayasasını oluşturmaya benzeyeceğidir (Anthropic’in “anayasal YZ“si bu fikri gerçek anlamıyla ele alıyor ve şirket yakın zamanda modelinin temel belgesine demokratik girdileri de dahil etmeyi denedi). Hükümetler, muazzam bir güce hükmeden karmaşık sistemlerdir. Üzerine kuruldukları temel milyonlarca insanın hayatını şimdi ve gelecekte etkileyebilir. Amerikalılar, halktan ödleri koptuğu için iki yüzyıldan fazla bir süre sonra siyasi sistemin baş belası olmaya devam eden anti-demokratik tedbirleri inşa etmiş ölü adamların boyunduruğu altında yaşamaktadır.

YZ geçmişteki herhangi bir yenilikten daha devrimci nitelikte olabilir. Ayrıca, tercihlerimizi yansıtmak için ne kadar çok inşa ettiğimiz göz önüne alındığında, norm getiren benzersiz bir teknolojidir. Jack Clark’ın yakın zamanda Vox’a söylediği gibi, “Bunun bir hükümet projesi olmaması gerçekten tuhaf bir şey.” Chalmers bana şöyle dedi: “Bir kere apansız bu hedefleri YZ sistemlerine yerleştirmeye çalışan teknoloji şirketlerine sahip olursak, bu çok derin sosyal ve politik soruları doğru yanıtlamaları için teknoloji şirketlerine gerçekten güvenmemiz gerekir, öyle değil mi? Ben güvenebileceğimden emin değilim.” Kendisi şunu vurguladı: “Bu konuda sadece teknik değil, aynı zamanda sosyal ve politik bir düşünme sürecindesiniz” diye de vurguladı.

Yanlış Seçimler

İnsanlığa öncelik vermeyen süper zeki sistemlerle karşılaşmak için beklememiz bile gerekmeyebilir. İnsanüstü araçlar önemseyebileceğimiz diğer her şey pahasına ödül için acımasızca optimizasyon yaparlar; Araç ne kadar yetenekli ve optimize eden ne kadar acımasız ise sonuçlar da o kadar aşırı olur.

Tanıdık geldi mi? Eğer öyleyse, yalnız değilsiniz. Yapay Zekâ Hedefleri Enstitüsü (AI Objectives Institute – AOI) hem kapitalizmi hem de yapay zekâyı yanlış hizalanmış uyumsuz optimize edicilerin örnekleri olarak görüyor. Eski radyo programı sunucusu Brittney Gallagher ve “mahremiyet kahramanı” Peter Eckersley tarafından -onun beklenmedik ölümünden kısa bir süre önce- ortaklaşa kurulan bu araştırma laboratuvarı, ““şimdiki zamanla keskin bir kopuştan ziyade, gücün daha az elde toplanması yönündeki mevcut eğilimlerin devamı olan -ve ilerleyen YZ tarafından aşırı yüklenen- imha ile ütopya arasındaki alanı inceliyor“ AOI Başkanı Değer Turan bana şunu söyledi: “Varoluşsal risk, bir risk karşısında eşgüdümün başarısız olmasıdır.” Turan, yapay zekâ güvenliği ile yapay zekâ etiği arasında “köprüler kurmamız gerekir” diyor.

X-Risk çevrelerindeki en etkili fikirlerden biri, tek bir aktörün tüm grubu mahvedebileceği durumlar için kullanılan bir terim olan “tek taraflılığın laneti”dir (unilateralist’s curse). Örneğin, bir biyolog grubu bir hastalığı daha ölümcül hale getirmenin bir yolunu keşfederse, bunu yayınlamak için sadece bir kişi yeterlidir. Geçtiğimiz birkaç on yıda pek çok kişi YZ’nin insanlığı yok edebileceğine inanmaya başladı, ancak içlerinden yalnızca en hırslı ve risk-müsamahakâr olanlar şu anda YZ yeteneklerinin sınırlarını zorlayan, ya da Sam Altman’ın yakın zamanda ima ettiği gibi “cehalet peçesini” geri iten şirketleri kurdu. CEO’nun da ima ettiği gibi, teknolojik sınırın ötesinde nelerin yattığını gerçekten bilmenin bir yolu yok.

Bazıları risklerin tamamen farkında ama gene de devam ediyorlar. ExxonMobil 1977’de, üst düzey bilim insanlarının yardımıyla, ürünlerinin küresel ısınmaya neden olduğunu kesin olarak keşfetmişti. Daha sonra petrol platformlarını daha yükseğe inşa ederken bu konuda kamuoyuna yalan söylediler.

Karbon yakmanın iklimi ısıtabileceğine ilişkin varsayım ilk olarak 19. yüzyılın sonlarında ortaya atıldı, ancak iklim değişikliği konusunda bilimsel mutabakatın oluşması neredeyse yüz yıl sürdü. Denetimi kalıcı olarak makinelere kaptırabileceğimiz fikri dijital bilgi işlem tekniğinden daha eskidir, ancak bilimsel mutabakattan hala çok uzaktır. Eğer yakın zamandaki YZ ilerlemelesi aynı hızla devam ederse, anlamlı adımlar atmamızı sağlayacak bir fikir birliğine ulaşmak için on yıllarımız kalmayabilir.

Kamusal alanda yaşanan tartışma, sizi YZ’nin acil zararları ile doğası gereği spekülatif olan varoluşsal riskleri arasında bir seçim yapmak gerektiğine inandırabilir. Oysa kesinlikle dikkatli bir değerlendirme gerektiren uzlaşmalar var.

Fakat burada rol oynayan maddi güçlere baktığınızda farklı bir tablo ortaya çıkıyor: Bir köşede YZ modellerini daha güçlü ve kârlı hale getirmeye çalışan trilyon dolarlık şirketler; diğer köşede ise YZ’nin düzenli olarak kâr maksimizasyonuyla çatışan değerleri yansıtmasını sağlamaya çalışan sivil toplum grupları var.

Kısacası, kapitalizm insanlığa karşı.

Garrison Lovely, The Nation ve Jacobin gibi sosyalist dergilere yazan, haberlerine ara sıra The New York Times, Time, The Guardian, BBC Future vb. ana akım basın-yayın organlarında da yer verilen Amerikalı bir serbest gazeteci ve “The Most Interesting People I Know” (Tanıdığım En İlginç İnsanlar) adlı podcastin sunucusudur. Geçen yıl çıkan “Obsolete: Power, Profit, and the Race for Machine Superintelligence” (Modası Geçmiş: Güç, Kâr ve Makine Süper Zekâsı İçin Yarış) adlı bir kitabı var. Bu makale ilk olarak 22 0cak 2024 tarihli Jacobin’de yayımlandı. Cengiz Onur Almancasından Türkçeye çevirdi, Mehmet Ali Ayan İngilizce orijinali ile karşılaştırarak gözden geçirdi.

Dipnotlar:

(1) Google DeepMind https://tr.wikipedia.org/wiki/Google_DeepMind

(2) Deep Learning / Derin Öğrenme https://tr.wikipedia.org/wiki/Derin_%C3%B6%C4%9Frenme

(3) X-Risk / Varoluşsal Risk https://tr.wikipedia.org/wiki/K%C3%BCresel_felaket_riski

(4) OpenAI https://tr.wikipedia.org/wiki/OpenAI

(5) LLM-Large Language Models / Geniş Dil Modelleri https://tr.wikipedia.org/wiki/Geni%C5%9F_dil_modeli

(6) AGI – Artificial General Intelligence/ Yapay Genel Zekâ

https://tr.wikipedia.org/wiki/Yapay_genel_zek%C3%A2

(7) Anthropic https://tr.wikipedia.org/wiki/Anthropic

(8) Etkili İvmecilik / Effective accelerationism https://tr.wikipedia.org/wiki/Etkili_ivmecilik

(9) EA – Effective altruism/etkili özgecilik https://tr.wikipedia.org/wiki/Etkili_%C3%B6zgecilik

(10) ivmecilik veya akselerasyonizm https://tr.wikipedia.org/wiki/%C4%B0vmecilik